在物联网(IoT)、工业互联网与实时应用需求爆发的背景下,边缘计算凭借 “就近处理数据” 的核心优势,成为解决中心化云计算 latency 过高、带宽成本高昂的关键技术。

而 Kubernetes(K8s)作为容器编排领域的事实标准,如何适配边缘环境的资源约束、网络不稳定等特性,实现边缘 workload 的高效管理?

本文将从架构分层、核心挑战、新兴解决方案三方面,系统拆解 Kubernetes 与边缘计算的融合路径,为企业落地边缘项目提供实操参考。

一、边缘计算与 Kubernetes 的协同逻辑:为何选择 K8s?

边缘计算的核心价值在于 “数据本地化处理”—— 将计算能力从云端下沉至靠近数据源头的设备(如 IoT 传感器、工业网关、边缘服务器),从而降低实时应用的响应延迟(如自动驾驶、工业控制)、减少云端数据传输量(降低带宽成本)、提升断网时的业务自主性。

而 Kubernetes 之所以能成为边缘计算的 “编排利器”,源于三大核心优势:

统一管理能力:无论云端集群还是边缘节点,均可通过 K8s 统一的 API 与控制器实现 workload 部署、扩缩容与监控,避免 “云端一套系统、边缘一套系统” 的割裂管理。

容器化适配性:边缘应用多为轻量、分布式场景,容器的 “一次打包、多环境运行” 特性,可解决边缘硬件异构(如 x86/ARM 架构)导致的应用兼容性问题。

生态扩展性:K8s 支持自定义资源(CRD)、控制器与插件,可无缝集成边缘专属工具(如边缘网关管理、设备通信协议),满足边缘场景的个性化需求。

但需注意:传统 K8s 为云端设计,直接部署到边缘会面临资源占用过高、依赖稳定网络等问题 —— 因此需通过 “架构分层优化” 与 “轻量化改造”,让 K8s 适配边缘环境。

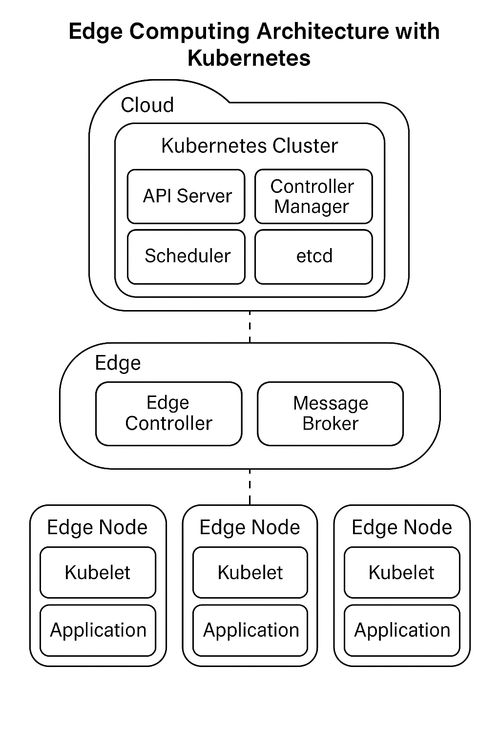

二、Kubernetes 边缘计算架构:三层协同模型

边缘计算与 K8s 结合的经典架构分为云端层、边缘层、设备层,三层通过协同实现 “云端管控 + 边缘执行 + 设备感知” 的闭环。每一层的 K8s 组件与功能定位各有侧重,具体如下:

- 云端层:K8s 的 “管控中枢”

云端层是整个边缘架构的管理核心,负责制定策略、分发配置、监控全局,不直接处理边缘实时数据。基于 K8s 构建的关键组件包括:

K8s 控制平面(Master):由 API Server、Scheduler、Controller Manager 组成,负责接收边缘节点的注册请求、调度边缘 workload(如根据边缘节点资源利用率分配 Pod)、维护集群状态(如边缘节点离线时的故障转移)。

容器镜像仓库:存储边缘应用的容器镜像(如 Docker Hub、Harbor 私有仓库),边缘节点通过拉取镜像实现应用部署(需配置镜像加速,避免边缘网络带宽不足导致的拉取超时)。

中心化监控与日志:通过 Prometheus 采集边缘节点的 CPU、内存、网络 metrics,结合 Grafana 生成可视化仪表盘;通过 ELK Stack(Elasticsearch+Logstash+Kibana)汇总边缘应用日志,实现问题排查与审计。

CI/CD 流水线:通过 Jenkins、GitLab CI 等工具,将边缘应用的代码编译、镜像构建、部署到边缘节点的流程自动化,避免人工操作导致的部署延迟与错误(如工业场景的固件升级需批量、快速完成)。

核心作用:将边缘节点视为 K8s 集群的 “远程节点”,实现 “统一管控、批量调度”,无需在边缘部署完整控制平面(降低边缘资源消耗)。

- 边缘层:K8s 的 “执行终端”

边缘层是计算能力的 “下沉载体”,直接对接设备层的数据源,负责实时数据预处理、本地化存储与短周期计算任务。由于边缘节点多为资源受限设备(如 2 核 4G 网关),需部署轻量化 K8s 发行版,核心组件包括:

轻量化 K8s 节点:采用 K3s 或 MicroK8s(而非传统 K8s)——K3s 移除了传统 K8s 中不必要的组件(如 InTree 存储插件、Legacy API),内存占用从传统 K8s 的 2GB + 降至 512MB 以下,支持 ARM/x86 架构,完美适配边缘网关。

边缘自定义控制器与 CRD:通过 K8s CRD 定义边缘专属资源(如 “IoT 设备”“边缘网关”),配合自定义控制器实现业务逻辑 —— 例如:当 IoT 传感器数据超过阈值时,控制器自动触发边缘应用的扩缩容。

本地数据处理组件:部署数据预处理工具(如 Flink Lite)对设备数据进行过滤、聚合(如将 1000 条传感器原始数据聚合为 1 条统计数据,再上传至云端),降低云端传输压力;通过 K8s PV/PVC 管理边缘节点的本地存储(如 SSD/HDD),存储临时数据或断网时的缓存数据。

消息 broker:部署 MQTT(轻量级 IoT 协议)或 NATS 服务,实现边缘设备与边缘节点的低延迟通信 —— 例如:IoT 摄像头通过 MQTT 将视频流片段发送至边缘节点,边缘节点进行实时人脸识别后,仅将结果(而非完整视频)上传至云端。

核心作用:在资源受限的边缘环境中,以最低开销实现 K8s 的 “编排能力”,同时处理本地化计算任务,减少对云端的依赖。

- 设备层:K8s 的 “感知触角”

设备层是数据的 “源头”,包括各类 IoT 终端(传感器、摄像头、工业 PLC)、嵌入式设备(如树莓派),本身不部署 K8s 组件,但通过 K8s 生态工具实现 “设备管理与状态监控”,关键组件与功能如下:

IoT 设备与通信协议:设备通过 MQTT、CoAP(低功耗协议)、LoRa(远距离协议)与边缘层通信 —— 例如:温湿度传感器每 10 秒通过 MQTT 向边缘节点发送数据。

边缘网关:作为设备层与边缘层的 “桥梁”,负责协议转换(如将 LoRa 协议转为 HTTP/MQTT)、数据聚合(将多个设备的数据汇总后发送至边缘节点)、设备接入控制(验证设备身份,防止非法接入)。

K8s 设备管理集成:通过 KubeEdge、OpenYurt 等工具,将设备层的 IoT 设备 “注册” 到 K8s 集群中,作为 “自定义资源” 管理 —— 例如:在 K8s 中查看某传感器的在线状态、历史数据上报频率,甚至通过 K8s API 远程控制设备(如重启摄像头)。

核心作用:让 K8s 集群 “感知” 边缘设备状态,实现 “应用 - 节点 - 设备” 的联动管理(如设备离线时,自动暂停依赖该设备的边缘应用)。

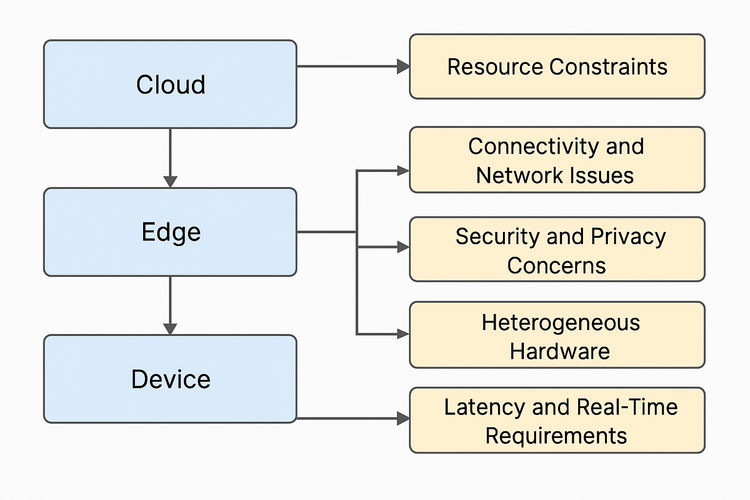

三、Kubernetes 边缘计算的核心挑战:5 大痛点解析

尽管 K8s 架构具备扩展性,但边缘环境的特殊性(资源少、网络差、硬件杂)仍会带来一系列挑战,这些挑战是企业落地时需优先解决的 “拦路虎”:

1. 资源约束:传统 K8s “太重”,边缘节点扛不住

边缘节点多为轻量级硬件(如 ARM 架构的网关、嵌入式设备),CPU、内存、存储资源有限 —— 而传统 K8s 控制平面(Master)需占用 2GB + 内存,Worker 节点需 1GB + 内存,直接部署会导致边缘节点资源耗尽,甚至无法运行业务应用。

典型场景:某工业场景使用 2 核 4G 的边缘网关,部署传统 K8s 后,仅 K8s 组件就占用 1.5GB 内存,剩余内存无法运行工业控制应用。

2. 网络不稳定:边缘与云端断连,业务 “停摆”

边缘设备常部署在网络条件差的环境(如户外基站、工厂车间),与云端的连接可能出现间歇性中断 —— 而传统 K8s 依赖稳定的网络实现 “节点与云端通信”(如 Pod 调度、状态上报),一旦断网,边缘节点将无法接收云端指令,甚至导致 workload 异常。

典型场景:某自动驾驶车辆的边缘节点(车载服务器)在隧道内断网,传统 K8s 无法与云端同步状态,导致车辆的实时路况分析应用暂停,影响行车安全。

3. 安全与隐私:边缘节点分散,防护难度大

边缘节点分布广泛(如遍布城市的 IoT 网关),物理安全难以保障(易被篡改、窃取数据);同时,边缘数据多为敏感信息(如工业生产数据、用户隐私数据),传输过程中存在泄露风险 —— 而传统 K8s 缺乏针对边缘场景的安全机制(如设备身份认证、数据加密传输)。

典型场景:某商场的边缘摄像头节点被非法入侵,攻击者窃取实时视频数据;边缘节点与云端传输数据时未加密,导致用户行为数据被拦截。

4. 硬件异构:边缘设备 “五花八门”,K8s 适配难

边缘环境的硬件架构多样,包括 x86(服务器)、ARM(网关、树莓派)、RISC-V(嵌入式设备),甚至专用芯片(如 AI 加速芯片)—— 传统 K8s 对异构硬件的支持有限,无法根据硬件特性调度 workload(如将 AI 推理任务调度到带 GPU 的边缘节点)。

典型场景:某边缘集群包含 x86 架构的计算节点与 ARM 架构的网关节点,传统 K8s 无法区分硬件架构,将仅支持 x86 的应用调度到 ARM 节点,导致应用启动失败。

5. 低延迟需求:K8s 调度 “耗时”,实时应用不满足

边缘场景的核心诉求之一是 “低延迟”(如工业控制需毫秒级响应、AR/VR 需亚毫秒级延迟)—— 而传统 K8s 的 Pod 调度、网络转发(如 Service/Ingress)存在一定耗时(通常 100ms+),无法满足实时应用的需求。

典型场景:某工业机器人的边缘控制应用,要求从传感器数据采集到执行指令的延迟不超过 50ms,但传统 K8s 的 Pod 启动与网络转发耗时达 150ms,导致机器人动作延迟,影响生产精度。

四、破局之道:5 大新兴解决方案与工具

针对上述挑战,业界已形成一批成熟的 K8s 边缘优化工具与方案,覆盖 “轻量化、断网自治、安全防护、硬件适配、低延迟” 五大核心需求,企业可根据场景选择组合使用:

- 轻量化 K8s 发行版:解决 “资源约束” 问题

核心思路是 “裁剪传统 K8s 冗余组件,降低资源占用”,主流工具包括:

K3s:由 Rancher 推出的轻量级 K8s,移除了传统 K8s 中的 etcd 集群(默认使用 SQLite 作为存储,适合单节点边缘场景)、InTree 存储插件、Legacy API,内存占用低至 512MB,支持 ARM/x86 架构,可通过一条命令部署(curl -sfL https://get.k3s.io | sh -),是边缘场景的 “首选方案”。

MicroK8s:由 Canonical 推出,主打 “零配置、快速部署”,支持单机模式(适合边缘网关)与集群模式(适合多边缘节点),内置 DNS、存储、Ingress 等组件,可通过 snap install microk8s --classic 一键安装,适合对易用性要求高的场景。

适用场景:边缘节点为 2 核 4G 以下的轻量硬件(如网关、嵌入式设备),需运行少量边缘应用(如数据采集、简单计算)。

- 边缘扩展平台:解决 “网络不稳定” 问题

核心思路是 “实现边缘节点的断网自治”—— 即使与云端断连,边缘节点仍能独立运行 workload,网络恢复后自动与云端同步状态,主流工具包括:

KubeEdge:华为开源的 K8s 边缘扩展平台,通过 “云端核心节点 + 边缘节点” 架构实现断网自治:

云端部署 KubeEdge 控制器(CloudCore),负责向边缘节点下发配置;

边缘节点部署 KubeEdge 代理(EdgeCore),内置 “本地缓存” 与 “离线任务执行” 能力,断网时可基于缓存的配置继续运行 workload;

支持 “边缘 - 云端数据同步”(如断网时的本地日志,网络恢复后自动上传至云端)。

OpenYurt:阿里开源的边缘原生 K8s 框架,通过 “节点亲和性改造” 与 “隧道通信” 实现断网自治:

将边缘节点标记为 “边缘节点”,K8s 调度时优先将 workload 部署到本地边缘节点,减少跨节点网络依赖;

边缘节点与云端通过 “YurtTunnel” 建立加密隧道,即使边缘节点使用内网 IP(无公网),也能与云端通信。

适用场景:边缘节点部署在网络不稳定环境(如户外、工厂),需保障断网时业务不中断(如工业控制、自动驾驶)。

- 边缘安全工具:解决 “安全与隐私” 问题

核心思路是 “从设备认证、数据传输、权限控制三方面构建安全防护体系”,主流方案包括:

服务网格(Istio/Linkerd):为边缘节点与云端、边缘节点之间的通信提供 “加密隧道”(mTLS),同时实现细粒度的访问控制(如仅允许特定边缘节点访问云端 API)、流量监控(检测异常数据传输)。

K8s Secrets + 加密存储:将边缘设备的认证信息(如 MQTT 用户名密码)、数据加密密钥存储在 K8s Secrets 中,结合边缘节点的本地加密存储(如加密硬盘),防止敏感数据泄露。

设备身份认证:通过 KubeEdge/OpenYurt 的设备管理模块,为每台 IoT 设备分配唯一 “设备证书”,边缘节点仅接收带有效证书的设备数据,防止非法设备接入。

适用场景:边缘数据包含敏感信息(如用户隐私、工业机密),或边缘节点分布在物理安全难以保障的区域(如户外基站)。

- 硬件适配工具:解决 “异构硬件” 问题

核心思路是 “让 K8s 识别硬件特性,实现 workload 与硬件的精准匹配”,主流方案包括:

K8s 设备插件(Device Plugin):为异构硬件(如 GPU、AI 加速芯片、传感器)编写设备插件,让 K8s 感知硬件资源(如 GPU 显存、AI 芯片算力),调度时根据 workload 的硬件需求分配资源 —— 例如:NVIDIA GPU 设备插件可让 K8s 识别 GPU,将 AI 推理应用调度到带 GPU 的边缘节点。

节点标签与亲和性:为不同硬件架构的边缘节点添加标签(如 node-role.kubernetes.io/arm: "true"、node-role.kubernetes.io/x86: "true"),在 workload 的 Deployment 中配置 “节点亲和性”(如 nodeSelector: {node-role.kubernetes.io/arm: "true"}),确保应用仅调度到适配的硬件节点。

适用场景:边缘集群包含多种硬件架构(如 ARM/x86)或专用芯片(如 AI 加速卡),需根据应用硬件需求精准调度。

- 低延迟优化方案:解决 “实时需求” 问题

核心思路是 “减少 K8s 调度与网络转发的耗时”,主流方案包括:

边缘本地调度:通过 KubeEdge/OpenYurt 将 “调度逻辑” 下沉到边缘节点 —— 云端仅制定调度策略,边缘节点根据本地资源状态(如 CPU 使用率、内存占用)实时调度 workload,减少云端 - 边缘通信耗时(从 100ms + 降至 10ms 以内)。

容器运行时优化:使用轻量级容器运行时(如 containerd 替代 Docker,或使用专为边缘优化的 CRI-O),减少容器启动耗时(从秒级降至毫秒级)。

HostNetwork 网络模式:对于实时性要求极高的应用(如工业控制),在 Pod 配置中使用 hostNetwork: true,让容器直接使用边缘节点的网络栈,避免 K8s Service/Ingress 的网络转发耗时(减少 50ms + 延迟)。

适用场景:边缘应用需毫秒级响应(如工业控制、AR/VR、自动驾驶)。

五、实践总结:Kubernetes 边缘计算的落地建议

企业在落地 K8s 边缘计算项目时,需避免 “一步到位” 的误区,建议按 “场景选型→试点验证→规模推广” 三步推进:

场景选型:根据边缘业务的核心诉求选择工具组合 —— 例如:

轻量边缘网关(2 核 4G)+ 断网自治需求:K3s + KubeEdge;

工业场景(异构硬件 + 低延迟):MicroK8s + 设备插件 + HostNetwork;

敏感数据场景(隐私保护):K3s + Istio + 加密存储。

试点验证:先在小规模边缘节点(如 3-5 个节点)部署核心应用,验证工具链的兼容性(如硬件是否支持、断网时业务是否正常)、性能指标(如延迟、资源占用),再逐步解决试点中发现的问题(如镜像拉取慢可添加边缘镜像仓库)。

规模推广:试点通过后,借助 K8s 的统一管控能力,批量部署边缘节点(可通过 KubeEdge/OpenYurt 的节点自动注册功能),同时完善监控与告警体系(如通过 Prometheus 监控边缘节点资源使用率,设置阈值告警),确保大规模运行的稳定性。

六、未来趋势:Kubernetes 边缘计算的演进方向

随着边缘计算的普及,K8s 边缘生态将向三个方向深化:

AI 与边缘的融合:更多 AI 推理任务将下沉至边缘(如实时人脸识别、工业质检),K8s 将通过 “AI 模型容器化”(如 TensorFlow Lite 容器)、“硬件算力调度”(如 AI 加速芯片设备插件),实现 AI workload 的边缘高效编排。

零信任安全普及:边缘节点的物理安全风险将推动 “零信任架构” 在 K8s 边缘场景的落地 —— 通过持续身份验证、最小权限访问、全链路数据加密,构建从设备到云端的端到端安全防护。

边缘原生 CRD 标准化:当前边缘工具(KubeEdge/OpenYurt)的自定义资源(如设备、网关)缺乏统一标准,未来可能形成行业通用的边缘 CRD 规范,实现不同边缘工具的 interoperability(互操作性)。

总之,Kubernetes 已成为边缘计算的 “核心编排平台”—— 通过轻量化改造、边缘扩展工具与安全方案的组合,可有效解决边缘场景的资源、网络、安全痛点。

对于企业而言,尽早基于 K8s 布局边缘计算,将在实时应用、IoT、工业互联网等领域抢占技术先机,实现业务的 “降本增效” 与 “创新突破”。