@TOC

引言:

嘿,亲爱的 Java 和 大数据爱好者们,大家好!在《大数据新视界》和《 Java 大视界》专栏的探索之旅中,我们已见证 Java 大数据在多个领域的惊艳表现。从《Java 大视界 -- 基于 Java 的大数据可视化在城市空气质量监测与污染溯源中的应用(216)》用数据可视化守护蓝天白云,到《Java 大视界 --Java 大数据在智能医疗远程手术机器人控制与数据传输中的技术支持(215》实现远程手术的 “零延迟” 突破;从智能家居的智能交互,到气象灾害的精准预警,Java 大数据不断改写行业规则。如今,在竞争白热化的电商战场,用户流失成为企业利润的 “隐形杀手”。Java 大数据与机器学习将如何携手,为电商企业筑起用户留存的 “数字长城”?让我们一同探寻答案。

正文:

一、电商行业用户流失现状与挑战

1.1 用户流失痛点深度剖析

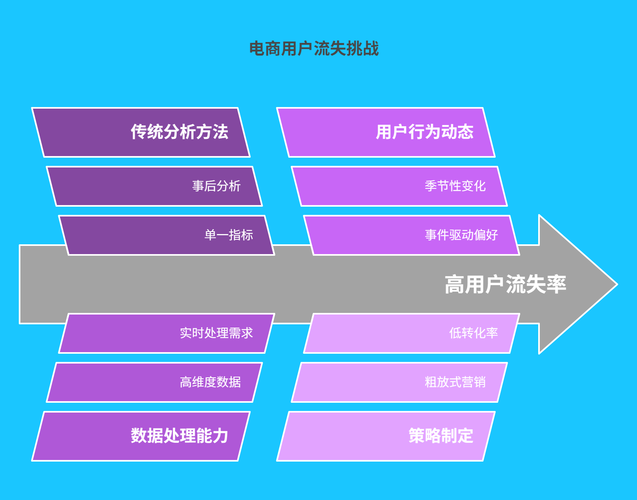

据《2024 年中国电商行业白皮书》显示,国内头部电商平台平均月流失率高达 8.7% ,中小平台更是突破 15% 。某知名快消电商平台曾因未能及时识别高流失风险用户,导致季度复购率骤降 12% ,直接造成 2.3 亿元 的营收损失。传统分析方法仅依赖 “近 30 天未下单” 等单一维度判定流失,如某服饰电商采用该方式,错失挽回 42% 潜在流失用户的机会,暴露出其无法捕捉用户隐性流失信号的致命缺陷。

| 指标 | 传统分析方法 | 存在问题 |

|---|---|---|

| 流失判定标准 | 单一行为指标(如订单间隔) | 忽略浏览习惯、评价情绪等多维数据 |

| 预测时效性 | 事后统计分析为主 | 无法提前 1 - 2 个月预警流失风险 |

| 策略制定 | 粗放式全员营销(如通用优惠券) | 用户触达精准度低,成本高且转化率不足 15% |

1.2 数据驱动的破局必然性

电商场景下,用户数据呈现 “三高” 特性 :

- 高维度:涵盖 12 类以上 数据(如浏览时长、加购路径、退货原因、客服沟通记录)

- 高实时性:日均产生 TB 级 行为日志,需分钟级处理

- 高动态性:用户偏好随季节、热点事件快速变化

唯有依托 Java 大数据构建 “感知 - 分析 - 决策” 闭环,才能将海量数据转化为留存竞争力。

二、Java 大数据技术基石

2.1 多源异构数据采集与整合

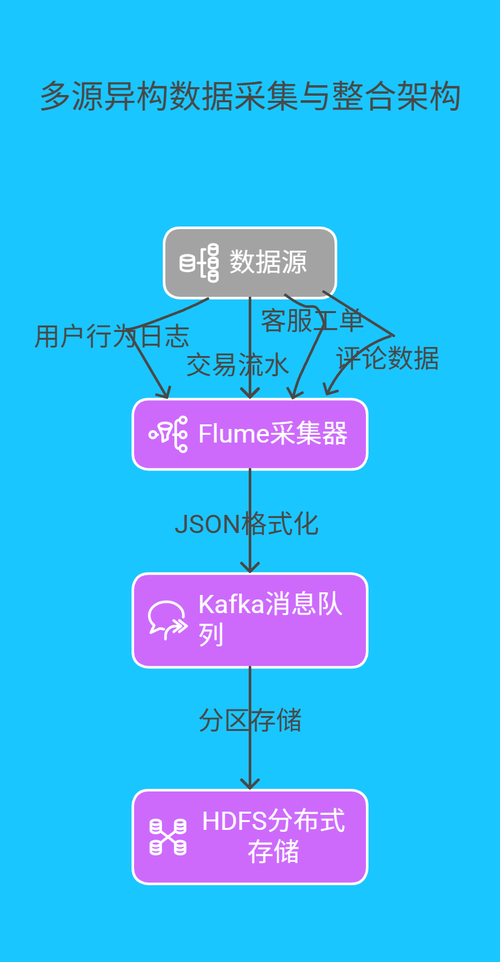

实时采集架构设计

- 采用 Flume + Kafka + HDFS 三级架构,实现数据的 “采集 - 缓冲 - 存储” 全链路处理:

- 核心代码实战(Flume 配置优化版)

# 定义source,采用exec类型实时监控日志文件 a1.sources.r1.type = exec # 监控用户行为日志文件,支持断点续读 a1.sources.r1.command = tail -F /var/logs/user_behavior.log # 配置source的拦截器,添加时间戳和UUID a1.sources.r1.interceptors = i1 i2 a1.sources.r1.interceptors.i1.type = timestamp a1.sources.r1.interceptors.i2.type = uuid # 定义channel,采用内存队列,设置容量与事务大小 a1.channels.c1.type = memory a1.channels.c1.capacity = 10000 a1.channels.c1.transactionCapacity = 1000 # 定义sink,输出到Kafka指定主题 a1.sinks.k1.type = org.apache.flume.sink.kafka.KafkaSink a1.sinks.k1.kafka.bootstrap.servers = kafka-cluster:9092 a1.sinks.k1.kafka.topic = user_data_topic # 绑定source、channel、sink,添加背压机制 a1.sources.r1.channels = c1 a1.sinks.k1.channel = c1 a1.sources.r1.backoffSleepIncrement = 100 a1.sources.r1.maxBackoff = 1000 2.2 机器学习模型全生命周期构建

2.2.1 特征工程的 “黄金三角”

基础特征:订单金额、购买频率、退货率

衍生特征:

-- 计算用户7日活跃度指数 SELECT user_id, (SUM(browse_count) * 0.3 + SUM(cart_count) * 0.5 + SUM(order_count) * 0.2) AS activity_score FROM user_behavior WHERE event_date >= CURDATE() - INTERVAL 7 DAY GROUP BY user_id;时序特征:通过滑动窗口提取近 1/3/7 天行为趋势

2.2.2 随机森林模型深度调优

import org.apache.spark.ml.classification.RandomForestClassifier; import org.apache.spark.ml.evaluation.MulticlassClassificationEvaluator; import org.apache.spark.ml.feature.VectorAssembler; import org.apache.spark.ml.tuning.*; import org.apache.spark.sql.SparkSession; import org.apache.spark.sql.Dataset; import org.apache.spark.sql.Row; public class ChurnModelTuning { public static void main(String[] args) { SparkSession spark = SparkSession.builder() .appName("ChurnModelTuning") .master("local[*]") .getOrCreate(); Dataset<Row> data = spark.read().csv("preprocessed_data.csv", true, "true"); // 特征组合 VectorAssembler assembler = new VectorAssembler() .setInputCols(new String[]{ "feature1", "feature2", ..., "feature20"}) .setOutputCol("features"); Dataset<Row> assembledData = assembler.transform(data); // 划分训练集与测试集 Dataset<Row>[] splits = assembledData.randomSplit(new double[]{ 0.8, 0.2}); Dataset<Row> trainingData = splits[0]; Dataset<Row> testData = splits[1]; // 定义随机森林模型 RandomForestClassifier rf = new RandomForestClassifier() .setLabelCol("is_churn") .setFeaturesCol("features"); // 定义参数网格搜索空间 ParamGridBuilder paramGrid = new ParamGridBuilder() .addGrid(rf.numTrees(), new int[]{ 50, 100, 150}) .addGrid(rf.maxDepth(), new int[]{ 3, 5, 7}) .build(); // 定义评估指标 MulticlassClassificationEvaluator evaluator = new MulticlassClassificationEvaluator() .setLabelCol("is_churn") .setMetricName("f1"); // 构建交叉验证器 TrainValidationSplit tvs = new TrainValidationSplit() .setTrainRatio(0.9) .setEstimator(rf) .setEvaluator(evaluator) .setEstimatorParamMaps(paramGrid); // 模型训练与调优 org.apache.spark.ml.tuning.TrainValidationSplitModel model = tvs.fit(trainingData); Dataset<Row> predictions = model.transform(testData); double f1Score = evaluator.evaluate(predictions); System.out.println("最优模型F1值: " + f1Score); } } 三、预测模型部署与留存策略闭环

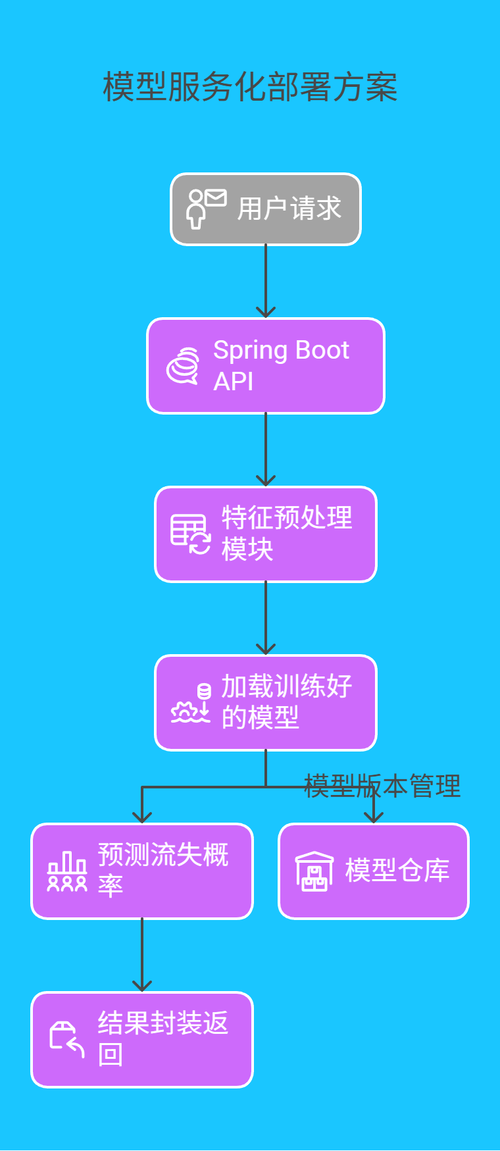

3.1 模型服务化部署方案

采用 Spark MLlib + Spring Boot 构建 RESTful 预测服务 :

关键代码片段(Spring Boot 接口):

import org.apache.spark.ml.classification.RandomForestClassificationModel; import org.springframework.web.bind.annotation.*; import java.util.HashMap; import java.util.Map; @RestController @RequestMapping("/churn") public class ChurnPredictionController { private final RandomForestClassificationModel model; public ChurnPredictionController() { // 加载训练好的模型,假设模型存储在HDFS this.model = RandomForestClassificationModel.load("hdfs://model_path"); } @PostMapping("/predict") public Map<String, Double> predict(@RequestBody Map<String, Object> userData) { // 特征转换逻辑 Map<String, Double> features = new HashMap<>(); features.put("feature1", (Double) userData.get("feature1")); // ... 其他特征处理 // 执行预测 double probability = model.predictProbability(features).toArray()[1]; Map<String, Double> result = new HashMap<>(); result.put("churn_probability", probability); return result; } } 3.2 动态分层留存策略矩阵

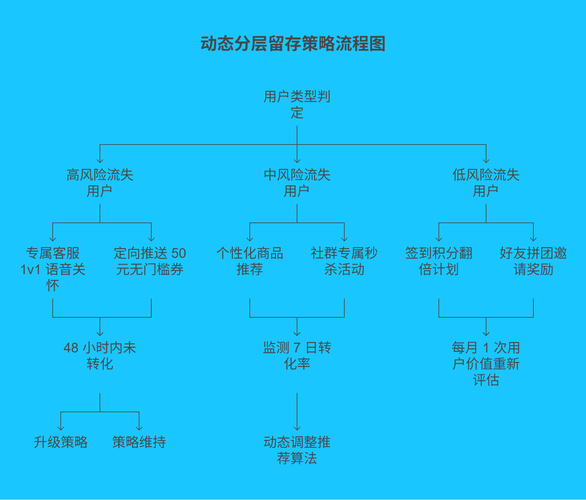

| 用户类型 | 判定标准 | 智能触达策略 | 效果追踪机制 |

|---|---|---|---|

| 高风险流失用户 | 概率 > 0.8,且 30 天未购 | ① 专属客服 1v1 语音关怀 ② 定向推送 50 元无门槛券 | 48 小时内未转化则升级策略 |

| 中风险流失用户 | 0.5 < 概率 <= 0.8 | ① 个性化商品推荐(基于协同过滤) ② 社群专属秒杀活动 | 监测 7 日转化率,动态调整推荐算法 |

| 低风险流失用户 | 概率 <= 0.5,且低频购买 | ① 签到积分翻倍计划 ② 好友拼团邀请奖励 | 每月 1 次用户价值重新评估 |

四、标杆案例:某电商巨头的实战突围

某日均千万订单的电商平台应用本方案后:

- 预测精度:AUC 值从 0.68 提升至 0.91 ,提前 2 个月识别 85% 的高流失用户

- 运营成本:精准营销使每用户留存成本降低 47% ,年度节省 3.2 亿元

- 商业价值:季度复购率提升 21% ,带动营收增长 6.1 亿元

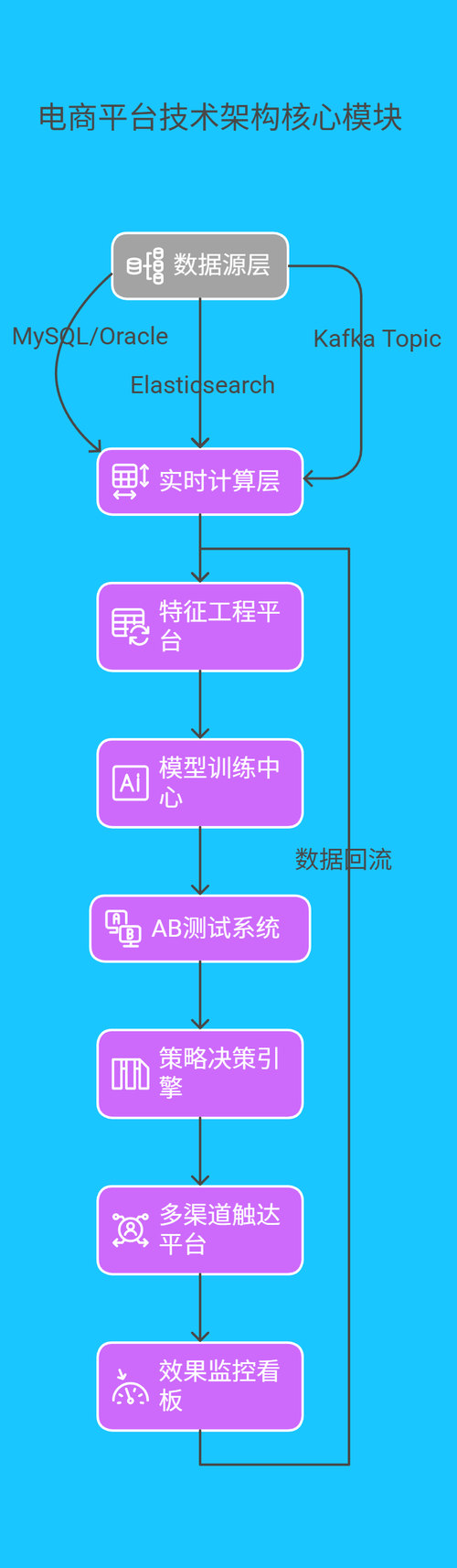

其技术架构核心模块如下:

结束语:

亲爱的 Java 和 大数据爱好者,从守护生态环境到守护用户资产,Java 大数据始终以 “代码为笔,数据为墨” 书写行业变革。在电商这场没有硝烟的战争中,机器学习模型成为企业克敌制胜的 “数字兵法”。《大数据新视界》和《 Java 大视界》专栏联合推出的第五个系列的第二十四篇文章 《Java 大视界 -- Java 大数据在智能物流运输车辆智能调度与路径优化中的技术实现(218)》将带我们深入物流网络,揭秘 Java 如何让百万辆货车实现 “智慧奔跑”。

亲爱的 Java 和 大数据爱好者,你在电商运营中遇到过哪些用户流失难题?认为哪种机器学习模型最适合预测用户流失?欢迎在评论区或【青云交社区 – Java 大视界频道】分享您的宝贵经验与见解。